robots.txtってどうすればいいのだろう?

robots.txtは難しい…。

このようなお悩みはありませんか?

robots.txtは、サイトの管理とSEOに役立ちます。正しく設定することで、クローラーの動きを制御し、サイトのパフォーマンスを最適化できます。

この記事では、初心者の方へ向けて、robots.txtの基本から書き方、設定方法、さらにはSEO効果やsitemap.xmlとの連携について解説します。

参考として、ぜひ最後までお読みください。

robots.txtとは何か

robots.txtとは、ウェブサイトの管理者が検索エンジンのクローラーに対してアクセス制御を行うためのテキストファイルです。このファイルを使うことで、特定のページやディレクトリのクロールを許可または禁止することができます。

例えば、管理画面や個人情報が含まれるページなど、公開する必要がない部分をクローラーから隠すことができます。

robots.txtはウェブサイトのルートディレクトリに配置し、検索エンジンが最初にアクセスするファイルの1つです。

クローラーとrobots.txtの関係

クローラーは、検索エンジンがウェブサイトの内容をインデックスするために使用するプログラムです。

クローラーがサイトを訪れると、最初にrobots.txtファイルを確認します。このファイルに記述された指示に従い、クロールするページやディレクトリを決定します。

例えば、「Disallow」コマンドを使用すると、特定のディレクトリやページへのアクセスを禁止することができます。

一方、「Allow」コマンドを使用すれば、特定のページのみクロールを許可することが可能です。

これにより、ウェブサイトの公開範囲を制御し、検索エンジンに適切な情報を提供することができます。

robots.txtを設定する理由とSEO効果

robots.txtを設定する理由は、主にウェブサイトの保護と検索エンジン最適化(SEO)の向上にあります。

適切に設定されたrobots.txtは、サイト内の重要な情報を守り、クローラーの効率的な動作をサポートします。

また、SEOにおいても、インデックスさせるべきページとそうでないページを区別することで、検索エンジンからの評価を高められます。

クローラーの制御とサイトの保護

robots.txtを使うことで、クローラーのアクセスを制御し、特定のページやディレクトリへのアクセスを禁止できます。

例えば、管理画面やユーザーの個人情報が含まれるページなど、一般公開する必要のない部分をクローラーから隠すことが可能です。

これにより、不必要なページが検索エンジンにインデックスされるのを防ぎ、サイトのセキュリティを向上させられます。

また、クローラーの負担を減らし、サーバーの負荷も軽減できます。

検索エンジン最適化(SEO)への影響

robots.txtは、SEOにおいても重要な役割を果たします。適切に設定されたrobots.txtは、検索エンジンがサイト内の重要なコンテンツを効率的にクロールし、インデックスするのを助けます。

さらに、低品質なページや重複コンテンツをクローラーから除外します。すると、高品質なコンテンツだけが検索エンジンに提供され、サイト全体の評価が向上します。

また、サイトマップをrobots.txtに指定すれば、クローラーにサイト内のすべての重要なページを知らせられます。これにより、効率的なクロールが促進されます。

robots.txtの利用が推奨されるケース

robots.txtの利用が特に推奨されるケースとして、以下のような状況が挙げられます。

まず、ウェブサイト内にインデックスさせたくないページやディレクトリがある場合です。

例えば、テスト環境やバックエンドの管理画面などです。

動的に生成される多数のページがあり、クローラーのクロールリソースを無駄に消費させたくない場合もあります。

また、大規模なサイトで特定の部分のみをクローラーにクロールさせることで、重要なコンテンツに集中させたい場合にも有効です。

最後に、サイトマップを指定してクローラーに効率的なクロールを促すことができるため、SEO効果を最大化するためにもrobots.txtの利用が推奨されます。

| ケース | 説明 |

|---|---|

| インデックスさせたくないページがある | テスト環境や管理画面など、公開する必要のないページをクローラーから隠す場合 |

| 自動生成される多くのページがある | 検索エンジンがクロールする必要がないページを除外し、リソースを節約したい場合 |

| 大規模なサイトで特定部分のみクロールさせたい | 重要なコンテンツにクローラーを集中させる場合 |

| サイトマップを指定したい | クローラーに効率的なクロールを促し、SEO効果を最大化したい場合 |

robots.txtの書き方と設定方法

robots.txtの書き方と設定方法は、ウェブサイトの管理者がクローラーのアクセスを制御するために重要です。

正しい構文と記述ルールを理解することで、適切にクローラーを誘導し、サイトのパフォーマンスを最適化できます。

最初に、robots.txtファイルの構文は以下のような形式で記述されます。

| plaintext User-agent: [クローラー名]Disallow: [アクセスを禁止するパス]Allow: [アクセスを許可するパス]Sitemap: [サイトマップのURL] |

| 命令 | 必須or任意 | 説明 |

|---|---|---|

| User-agent | 必須 | クローラーを指定します。特定のクローラーまたはすべてのクローラーに対して設定を適用します。 |

| Disallow | 任意 | クローラーがアクセスを禁止するパスを指定します。 |

| Allow | 任意 | Disallowで禁止した中でもアクセスを許可するパスを指定します。 |

| Sitemap | 任意 | サイトマップのURLを指定し、クローラーにサイト全体の構造を知らせます。 |

【User-agentの指定方法】

User-agentは、特定のクローラーに対して指示を与えるために使用されます。

一般的な指定方法は以下の通りです。

| plaintext User-agent: * |

アスタリスク(*)を使うと、すべてのクローラーに適用される設定になります。特定のクローラーのみを対象とする場合は、そのクローラーの名前を指定します。

その他クローラーの例

- Googlebot(Googleの検索エンジンクローラー)

- Bingbot(Bingの検索エンジンクローラー)

- Slurp(Yahooの検索エンジンクローラー)

- DuckDuckBot(DuckDuckGoの検索エンジンクローラー)

- Baiduspider(Baiduの検索エンジンクローラー)

| plaintext User-agent: Googlebot |

上記の例では、Googlebotのクローラーに適用される設定になります。

【Disallowの使い方】

Disallowは、クローラーがアクセスできないパスを指定するために使用します。

以下はその例です。

| plaintext User-agent: *Disallow: /admin/Disallow: /private/ |

上記の例では、すべてのクローラーに対して「/admin/」と「/private/」ディレクトリへのアクセスを禁止しています。

各ページの末端のURLを指定しています。

【Allowの使い方】

Allowは、Disallowで禁止した中でもアクセスを許可したいパスを指定するために使用します。

以下はその例です。

| plaintext User-agent: *Disallow: /private/Allow: /private/public/ |

この例では、「/private/」ディレクトリ全体を禁止しています。しかし、その中の「/private/public/」ディレクトリはアクセスを許可しています。

【Sitemapの指定方法】

Sitemapは、サイトマップのURLを指定するために使用します。これにより、クローラーはサイト内のすべてのページを効率的にクロールできます。

以下はその例です。

| plaintext User-agent: *Sitemap: https://www.example.com/sitemap.xml |

この例では、サイトマップのURLを「https://www.example.com/sitemap.xml」として指定しています。

これにより、クローラーはこのURLからサイト全体の構造を把握し、効率的にクロールを行うことができます。

robots.txtファイルの作成手順

robots.txtファイルを正しく作成し、適切な場所に配置することは、ウェブサイトのSEOとクローラー管理において重要です。

以下に、テキストエディタを使ったファイルの作成方法と、アップロード手順について説明します。

テキストエディタを使ったファイル作成

robots.txtファイルを作成するには、まずテキストエディタを使用します。Windowsではメモ帳、Macではテキストエディットなど、どんなテキストエディタでも構いません。

以下の手順で進めます。

- テキストエディタを開きます。

- 必要な命令を記述します。例として、以下のような内容を入力します。

| plaintext User-agent: *Disallow: /admin/Allow: /public/Sitemap: https://www.example.com/sitemap.xml |

3. 記述が完了したら、ファイルを保存します。保存時のファイル名は必ず「robots.txt」にします。拡張子が.txtであることを確認してください。

robots.txtファイルのアップロード方法

作成したrobots.txtファイルをウェブサーバーにアップロードする必要があります。

ここでは、サーバーのルートディレクトリに配置する方法と、WordPressなどのCMSでの配置方法について説明します。

【サーバーのルートディレクトリに配置する方法】

- FTPクライアントソフト(例:FileZilla)を使用して、ウェブサーバーに接続します。

- サーバーのルートディレクトリ(一般的には「public_html」や「www」など)に移動します。

- 作成した「robots.txt」ファイルをルートディレクトリにアップロードします。

- アップロードが完了したら、ウェブブラウザで「https://www.example.com/robots.txt」にアクセスし、正しく配置されているか確認します。

【WordPressなどのCMSでの配置方法】

WordPressなどのCMSを使用している場合、以下の方法でrobots.txtファイルを配置します。

- FTPクライアントソフト(例:FileZilla)を使用して、ウェブサーバーに接続します。

- WordPressのインストールディレクトリに移動します。通常、ルートディレクトリに配置されています。

- 作成した「robots.txt」ファイルをインストールディレクトリにアップロードします。

- アップロードが完了したら、ウェブブラウザで「https://www.example.com/robots.txt」にアクセスし、正しく配置されているか確認します。

これで、robots.txtファイルの作成と配置が完了です。

robots.txtの確認とテスト

robots.txtファイルを作成・配置した後は、その動作を確認し、正しく設定されているかをテストすることが重要です。

適切な動作を確認することで、クローラーが意図した通りにウェブサイトをクロールするようにします。

以下に、動作確認方法とエラー修正手順について説明します。

robots.txtファイルの動作確認方法

robots.txtファイルの動作を確認するには、いくつかの方法があります。

最も一般的なのは、Google Search Consoleを使ったテストと、その他のvalidatorツールを使用する方法です。

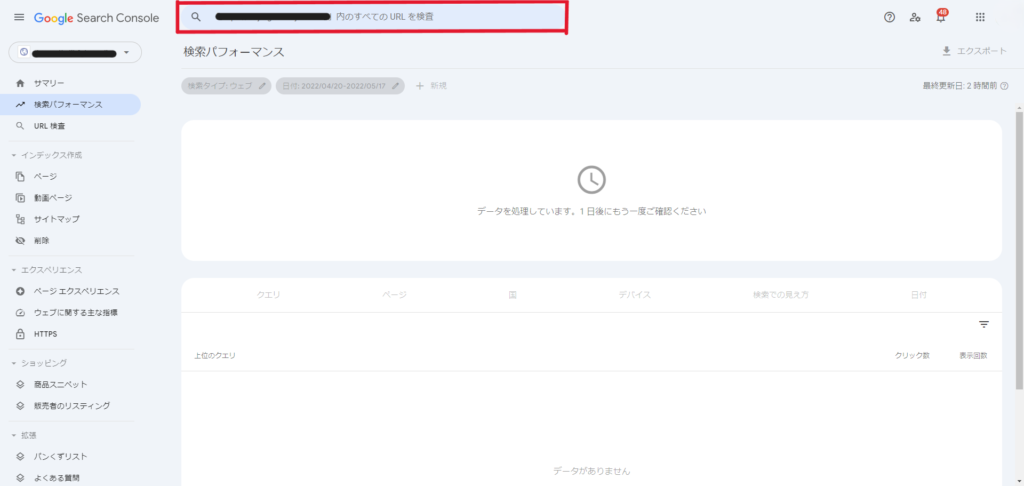

Google Search Consoleを使ったテスト

Google Search Consoleを使うと、robots.txtファイルの設定を簡単にテストできます。以下の手順で進めます。

- Google Search Consoleにログインします。

- 確認したいサイトを選択します。

- 左側のメニューから「設定」>「robots.txtテスター」を選びます。

- 現在のrobots.txtファイルの内容が表示されます。テストしたいURLを入力し、「テスト」ボタンをクリックします。

- クローラーがそのURLにアクセスできるかどうかの結果が表示されます。

このツールを使うことで、Googlebotが特定のURLにアクセスできるかどうかを確認できます。

その他のvalidatorツールの紹介

Google Search Console以外にも、robots.txtファイルの動作を確認するためのvalidatorツールがあります。以下は、その一部です。

| ツール名 | 説明 |

|---|---|

| Robots.txt Checker | robots.txtファイルの内容を解析し、設定の正確性を確認します。 |

| SEO Site Checkup | サイト全体のSEO診断の一部としてrobots.txtファイルをテストします。 |

| MXT Toolbox | 詳細な解析を行い、エラーや警告を表示します。 |

これらのツールを使用することで、robots.txtファイルが意図した通りに機能しているかどうかを多角的に確認できます。

エラーの修正と更新手順

robots.txtファイルにエラーが見つかった場合、迅速に修正することが重要です。

以下の手順でエラーを修正し、ファイルを更新します。

- テキストエディタでrobots.txtファイルを開きます。

- エラー箇所を修正します。

- →例えば、DisallowやAllowのパスが間違っている場合、正しいパスに修正します。

- 修正が完了したら、ファイルを保存します。

- 修正済みのrobots.txtファイルを再度サーバーにアップロードします。

- Google Search Consoleや他のvalidatorツールを使用して、再度動作確認を行います。

これでエラーの修正と更新が完了です。

定期的にrobots.txtファイルを確認し、必要に応じて更新しましょう。クローラーの適切な動作を維持し、SEO効果を最大化できます。

robots.txtとsitemap.xmlの関係

robots.txtファイルとsitemap.xmlを適切に設定し連携させることができます。

そうすることで、検索エンジンにとって効率的なクロールを実現し、ウェブサイトのインデックス品質を向上させることができます。

Sitemapの役割とメリット

sitemap.xmlは、ウェブサイト内のすべてのページのリストを提供し、検索エンジンのクローラーがサイト全体を効率的にクロールするためのガイドとなります。役割として、ページの一覧を提供することができます。

サイト内のすべてのページをクローラーに知らせることが可能です。これには、新しいページや更新されたページも含まれます。

メリットとして、「クロール効率の向上」と「インデックスの向上」が見込めます。

クローラーが重要なページを優先的にクロールできるようにし、全ページを正確にインデックスできるようにサポートします。

robots.txtとsitemap.xmlを連携させる方法

robots.txtファイルとsitemap.xmlを連携させるには、robots.txtファイル内にsitemap.xmlの場所を明示的に記述します。

以下はその手順です。

- robots.txtファイルを開く

- →テキストエディタを使ってrobots.txtファイルを開きます。

- sitemap.xmlの記述を追加

- →ファイルの末尾に以下のように記述します。

| plaintext Sitemap: https://www.example.com/sitemap.xml |

- ファイルを保存しアップロード

- →記述を追加したrobots.txtファイルを保存し、ウェブサーバーのルートディレクトリにアップロードします。

- 確認

- →ウェブブラウザで「https://www.example.com/robots.txt」にアクセスし、正しく記述されているか確認します。

robots.txtのよくある質問

robots.txtはウェブサイトの管理者にとって便利なツールですが、利用する際にいくつかの疑問や問題が生じることがあります。

ここでは、よくある質問とその対処法について解説します。

robots.txtでブロックされた場合の対処法

- robots.txtファイルを確認する

- →まず、robots.txtファイルを開き、該当するDisallowルールを見つけます。

- ファイルの開き方がわからない方は、前述したアップロード

- ブロックされたページのパスを修正する

- →該当するページのパスが間違っている場合、正しいパスに修正します。

- Disallowルールを削除する

- →もし特定のページやディレクトリのブロックが不要であれば、該当するDisallowルールを削除します。

- ファイルを保存してアップロードする

- →修正後、robots.txtファイルを保存し、ウェブサーバーに再アップロードします。

- Google Search Consoleで確認する

- →Google Search Consoleの「robots.txtテスター」を使用して新しい設定をテストします。

noindexタグとの違いと使い分け

robots.txtとnoindexタグは、いずれも検索エンジンに対するインデックス制御を行うための手段です。しかし、使い方や効果に違いがあります。

robots.txt

- 目的:クローラーが特定のページやディレクトリにアクセスすること自体を禁止する。

- 適用方法:robots.txtファイルにDisallowルールを記述する。

- 効果:指定されたパスへのアクセスが完全にブロックされるため、そのページはインデックスされない。

noindexタグ

- 目的:クローラーがページにアクセスすることは許可するが、そのページを検索エンジンのインデックスに含めない。

- 適用方法:HTMLページのヘッダー部分に以下のメタタグを追加する。

| html <meta name=”robots” content=”noindex”> |

- 効果:クローラーはページにアクセスできるが、インデックスには含まれない。

使い分け

- robots.txtを使用する場合:管理画面や個人情報が含まれるページなど、クローラーに一切アクセスさせたくない場合に適しています。

- noindexタグを使用する場合:クローラーがページの内容を理解することは許可するが、検索結果に表示させたくない場合に適しています。例えば、検索結果には表示させたくないが、他のページからのリンク評価を受けたい場合などです。

robots.txtのトラブルシューティング

robots.txtファイルを設定しても、クローラーが意図通りに動かないことや、変更が反映されないことがあります。

ここでは、こうしたトラブルが発生した場合の対処法を解説します。

クローラーが意図した通りに動かない場合の対処法

クローラーがrobots.txtの設定通りに動かない場合、以下の手順を試して問題を解決します。

- ファイルの構文エラーを確認する:robots.txtファイルの記述に誤りがないか確認します。特に「User-agent」や「Disallow」などのスペルミスや不適切な記述に注意します。

- テストツールを使用する:Google Search Consoleの「robots.txtテスター」を使用して、設定が正しく認識されているか確認します。テスターにURLを入力して、アクセスが許可されているかどうかを確認します。

- キャッシュをクリアする:クローラーが古いrobots.txtファイルをキャッシュしている場合があります。Google Search Consoleで「インデックス」 > 「URL検査」からURLを検査し、キャッシュを更新します。

- 特定のクローラーの指定を確認する:対象のクローラーが正しく指定されているか確認します。クローラー名のスペルミスや間違いがないか再確認します。

robots.txtの更新が反映されない場合の確認ポイント

robots.txtファイルを更新しても、その変更が反映されない場合、以下の確認ポイントをチェックします。

- ファイルの保存とアップロードを確認する:更新後、robots.txtファイルが正しく保存され、ウェブサーバーにアップロードが完了したか確認します。

- キャッシュの問題を解消する:ブラウザやサーバーのキャッシュが原因で変更が反映されていない場合があります。ブラウザのキャッシュをクリアし、サーバー側のキャッシュも確認します。

google のキャッシュをクリアにする方法はコチラをご覧ください。

サーバーのキャッシュをクリアにする方法は以下をご覧ください。

(Conoha Wing をお使いの方はコチラ)

(Xserver をお使いの方はコチラ) - サーバー設定を確認する:サーバー設定に問題がある場合、robots.txtファイルが正しく読み込まれないことがあります。特に.htaccessファイルやサーバーの設定ファイルを確認し、robots.txtファイルへのアクセスが許可されていることを確認します。

- 再クロールをリクエストする:Google Search Consoleで「インデックス」 > 「URL検査」から再クロールをリクエストし、新しいrobots.txtファイルが認識されるようにします。

まとめ

robots.txtは、ウェブサイトの管理者がクローラーのアクセスを制御し、サイトのセキュリティやSEOの最適化を図るために重要なファイルです。本記事では、robots.txtの基本的な構文と記述ルール、作成手順、確認方法、そしてsitemap.xmlとの連携について解説しました。

robots.txtを適切に設定することで、クローラーが意図した通りにサイトをクロールし、重要なページが正しくインデックスされるようになります。これにより、検索エンジンからの評価を高め、SEO効果を最大化することができます。

最後に、robots.txtとsitemap.xmlを連携させることで、クローラーが効率的にサイト全体をクロールできるようにすることも重要です。

これにより、ウェブサイトの全ページが適切にインデックスされ、検索エンジンからの評価がさらに向上します。

ウェブサイトの健全な運営とSEOの向上のために、定期的にrobots.txtファイルを見直し、必要に応じて更新していきましょう。